Interação Homem-Máquina

Projeto de Iniciação Científica

Introdução

E se as máquinas pudessem nos entender — não pelo que dizemos ou tocamos, mas pelos sinais que nossos músculos emitem antes mesmo do movimento acontecer? A área de Interfaces Cérebro-Computador (BCI) está transformando essa pergunta em sistemas reais — e este projeto se posiciona na fronteira dessa transformação.

A Interação Humano-Computador (HCI) evoluiu de ferramentas manipuláveis para ambientes responsivos. Começou com teclados, mouses e interfaces gráficas, mas agora alcança um ponto em que os sinais gerados pelo próprio corpo humano se tornam base para a comunicação. Este projeto explora essa transição — desenvolvendo uma arquitetura BCI não invasiva baseada em sinais eletromiográficos (EMG) captados do antebraço, utilizando a pulseira Myo como dispositivo de entrada biológica.

Esses sinais, processados e interpretados em tempo real, são mapeados para comandos acionáveis capazes de controlar dispositivos externos. O sistema propõe uma nova concepção de interface — que emerge da intenção, e não apenas da interação, colocando o corpo no centro do processo computacional.

Enraizado em fundamentos científicos como potenciais de ação, ativação de unidades motoras e propagação bioelétrica, este trabalho reconstrói o EMG não como ruído a ser filtrado, mas como informação estruturada, passível de interpretação, tradução e integração em sistemas inteligentes. O que começa como um impulso muscular se transforma em uma ponte comunicativa entre usuário e máquina.

O projeto entrega um protótipo funcional e um modelo de sistema escalável que demonstra como sinais biológicos podem substituir entradas mecânicas tradicionais. Sua aplicação vai além da exploração acadêmica — aponta para um futuro de sistemas de controle bioadaptativos, em tempo real, aplicáveis a múltiplos contextos.

Nesse paradigma, a interação deixa de ser apenas funcional — ela se torna inclusiva. Para pessoas com mobilidade reduzida ou deficiências físicas, as interfaces tradicionais não são apenas inconvenientes; são barreiras. Ao permitir a interação por meio de sinais internos, este projeto propõe uma alternativa: tecnologias que se adaptam ao usuário — e não o contrário.

Ele também nasce de uma convicção pessoal: a de que a tecnologia deve ser instrumento de autonomia, e não de dependência. Deve potencializar capacidades humanas, e não contornar suas limitações.

Inspirado por discussões contemporâneas sobre design ético e sistemas inclusivos, este trabalho contribui para um futuro em que os dispositivos não apenas respondem — eles compreendem. Um futuro onde o controle começa não pelo toque, mas pela consciência.

Desenvolvimento

Uma das direções mais promissoras no campo do design de interação está no desenvolvimento de sistemas baseados em gestos — tecnologias que permitem aos usuários se comunicarem com máquinas por meio de movimento, intenção e sinais biométricos, sem depender de métodos convencionais de entrada. Este projeto avança nesse sentido ao implementar um sistema vestível capaz de capturar a atividade neuromuscular e traduzi-la em comandos funcionais, em tempo real, por meio de uma Interface Cérebro-Computador (BCI).

No centro do sistema está a pulseira Myo, um dispositivo vestível que capta a atividade elétrica dos músculos do antebraço por meio de um conjunto de oito sensores de eletromiografia (EMG), integrados a um giroscópio, acelerômetro e magnetômetro. Esses sensores permitem interpretar contrações musculares e movimentos do braço com alta precisão. Do ponto de vista técnico, o Myo atua não apenas como plataforma de captação, mas como ponte entre a intenção humana e o comportamento da máquina.

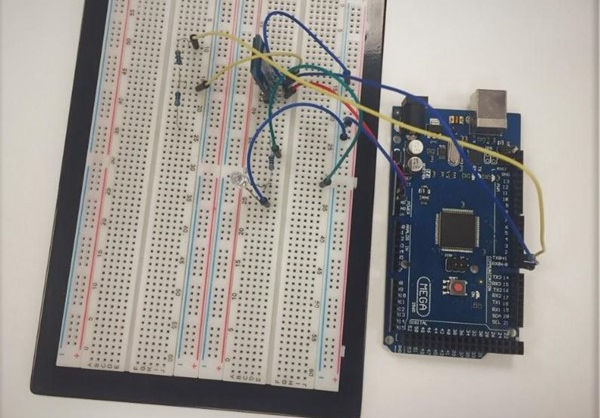

A arquitetura do sistema integra três componentes principais: o Myo para aquisição de sinais; um aplicativo Android personalizado, responsável pela interpretação dos dados em tempo real e pela lógica dos comandos (desenvolvido com o SDK do Myo); e um módulo de hardware baseado em Arduino, que executa ações com base nos sinais recebidos. Esses elementos se comunicam via Bluetooth, permitindo a transmissão de gestos a dispositivos físicos — como lâmpadas ou atuadores — de forma fluida e sem a necessidade de contato físico.

Mais do que uma inovação técnica, essa configuração representa um modelo prático e escalável de neurotecnologia inclusiva. Ao combinar ferramentas de baixo custo, código aberto e processamento de sinais EMG em tempo real, o sistema transforma obstáculos tradicionais — como preço, complexidade e acessibilidade — em oportunidades para uma aplicação social mais ampla.

O uso de uma plataforma móvel como camada intermediária amplia a mobilidade e usabilidade do sistema. Em um mundo em que os smartphones se tornaram praticamente onipresentes, integrar o controle por BCI a esses dispositivos garante um alcance maior — especialmente para usuários em contextos de menor acesso tecnológico. Além disso, permite maior flexibilidade para expandir a funcionalidade do sistema — seja em casas inteligentes, próteses ou interfaces imersivas.

No cerne deste sistema está a ideia de que o próprio corpo humano pode ser a interface — capaz de controlar o ambiente por meio da intenção, e não apenas do toque. Aqui, a atividade muscular deixa de ser um ruído de fundo e passa a ser reconhecida como um canal legítimo de comunicação e autonomia.

E para além da interface, este é um modelo de design ético de sistemas. Ele parte de um princípio frequentemente negligenciado no desenvolvimento de tecnologias emergentes: o de que a inovação deve começar pelas pessoas. Ao usar os sinais do próprio corpo como base para o controle, este sistema propõe um futuro em que a acessibilidade não seja uma adaptação posterior, mas um fundamento do projeto desde o início.

Projeto

O desenvolvimento deste sistema seguiu uma trajetória metódica e exploratória — iniciando com experimentações fundamentais de prova de conceito e culminando em um protótipo funcional, orientado para o ser humano. Em cada etapa, o objetivo não foi apenas validar a viabilidade técnica, mas também refinar a tradução da intenção biológica em interação tangível.

A fase inicial consistiu em testar um gesto simples: o fechamento do punho. Quando detectado pela pulseira Myo, o sinal eletromiográfico (EMG) era transmitido via Bluetooth e utilizado para acionar uma saída básica — um LED conectado a uma placa Arduino. Embora elementar, esse experimento confirmou a integridade de toda a estrutura de neurointeração: da aquisição e processamento do sinal à transmissão sem fio e resposta física. Este marco serviu como base para expandir o sistema de forma confiável e coerente.

A partir disso, o projeto evoluiu para um protótipo mais sofisticado, voltado à automação residencial por meio de gestos. O usuário passou a controlar uma lâmpada comum com um único movimento, sem necessidade de interruptores físicos. Mais do que uma melhoria funcional, esse resultado representou uma mudança de paradigma na forma como os ambientes podem reagir ao corpo humano. A interação passou a ser fluida, sem contato e orientada pela intenção — redefinindo os conceitos de acessibilidade e controle.

A arquitetura técnica que tornou isso possível foi projetada com precisão. Os sinais EMG foram filtrados por meio de técnicas de bandpass (20–250 Hz) e suavizados com RMS (root-mean-square) para reduzir ruídos e aprimorar a acurácia na identificação dos gestos. Os sinais foram então classificados e enviados via módulos Bluetooth HC-05 a um microcontrolador Arduino, que executava o comando físico. Um aplicativo Android desenvolvido sob medida proporcionava feedback em tempo real e visualização dos sinais, garantindo total responsividade e transparência do sistema.

O resultado foi a criação da plataforma “On House” — um ambiente inteligente modular controlado inteiramente pela intenção muscular. A plataforma é, ao mesmo tempo, um protótipo técnico e um modelo conceitual. Ela demonstra como ambientes cotidianos podem se tornar mais acessíveis e adaptativos quando redesenhados sob a ótica da neurotecnologia inclusiva.

Apresentado na 7ª edição do SEMIC (Seminário de Iniciação Científica da ESPM), o projeto atraiu atenção acadêmica por sua síntese multidisciplinar de neurociência, design de sistemas, processamento de sinais e interação humano-computador. Mais do que isso, abriu espaço para discussões mais amplas sobre o potencial ético das interfaces cérebro-computador: como tecnologias baseadas na leitura de sinais biológicos podem servir não apenas à função, mas à liberdade.

No fim, este projeto demonstra algo que vai além da viabilidade técnica de um sistema de controle por gestos. Ele prova que tais sistemas podem ser inclusivos, escaláveis e fundamentados em propósito humano. Revela uma filosofia de design que prioriza autonomia sobre novidade, corporeidade sobre abstração e acesso sobre complexidade.

No essencial, este não é apenas um protótipo — é uma declaração: de que a interação não deve ser um privilégio mediado por ferramentas, mas um direito restaurado pela intenção.

Direções Futuras

Este projeto não representa um ponto final — é a fundação de uma visão de pesquisa mais ampla. A validação da interação em tempo real, de forma não invasiva, por meio da captação de sinais EMG, é apenas o começo do que sistemas neuroadaptativos podem se tornar. Os próximos passos incluem a integração de algoritmos de aprendizado de máquina para refinar o reconhecimento de gestos e construir modelos adaptativos que aprendam com o perfil neuromuscular de cada usuário. Esses sistemas poderão ser expandidos para controlar neuropróteses, ambientes imersivos e interfaces multimodais — respondendo simultaneamente a sinais musculares, movimentos e padrões cognitivos.

Mas com capacidade vem também a responsabilidade. À medida que máquinas passam a interpretar sinais internos do corpo — tensões, intenções e microgestos — a pergunta deixa de ser apenas como elas devem responder, e passa a ser como elas devem respeitar. O design de interação se torna uma questão ética: como codificar dignidade em sistemas que decodificam biologia? Como garantir privacidade, consentimento e agência em tecnologias que sentem e atuam sobre expressões humanas? Essas não são considerações teóricas — são decisões estruturais que precisam ser incorporadas desde a base dos sistemas.

Este projeto transformou minha visão sobre inovação. Ela não é apenas resultado técnico, mas um ato moral. Sinais não são apenas dados — são expressões de vontade. Construir sistemas que os interpretem exige mais do que precisão; exige cuidado. Eu entendo a interação entre humanos e máquinas não como um problema de eficiência, mas como um espaço para reinventar conexões. Sistemas neuroadaptativos têm o potencial de não apenas responder — mas de compreender, de se adaptar, e de reconhecer o ser humano por trás do sinal.

Meu compromisso é desenvolver tecnologias que partam do corpo e respeitem sua linguagem. Enxergo um futuro em que a interação não começa com o toque, mas com a consciência — onde o controle não é imposto, mas reconquistado. Por meio de pesquisa interdisciplinar, design ético e pensamento inclusivo, pretendo contribuir para um futuro em que a neurotecnologia amplifique a autonomia, restaure capacidades e seja projetada com a humanidade no centro.

Olhando para o futuro, esse trabalho abre as portas para a neuroprostética adaptativa, sistemas de controle háptico e estruturas éticas para a interpretação de sinais de IA. Ele também moldou minha filosofia de pesquisa: que os sinais que interpretamos não são apenas dados - são expressões de autonomia, esforço e identidade. A tecnologia, quando projetada com intenção, pode restaurar o controle para aqueles excluídos pelos sistemas convencionais.